Goal

1. 역전파(Backpropagation)의 기본적인 원리 이해하기

2. 역전파 계산 논리 알아보기

딥러닝을 공부하면 역전파(backpropagation) 개념을 피해갈 수 없는데 알고나면 생각보다 어렵진 않다! 그리고 딥러닝 모델을 만드는데 정말 중요한 개념이라는걸 알 수 있다.

역전파(Backpropagation)란?

딥러닝 모델이 출력한 예상 값과 실제 값에는 차이가 있다. 간단하게 예를 들자면 고양이 사진을 input으로 넣었을 때 딥러닝 모델이 고양이가 아니라고 예측(0 이라고 예측)한다면 실제 값인 고양이가 맞다(1 이라는 값)과는 1 - 0 = 1 의 차이가 있다.

이러한 실제 값과 예상 값의 차이를 줄여나가기 위해 역전파(backpropagation)를 이용하게 된다.

Loss function과 Cost function

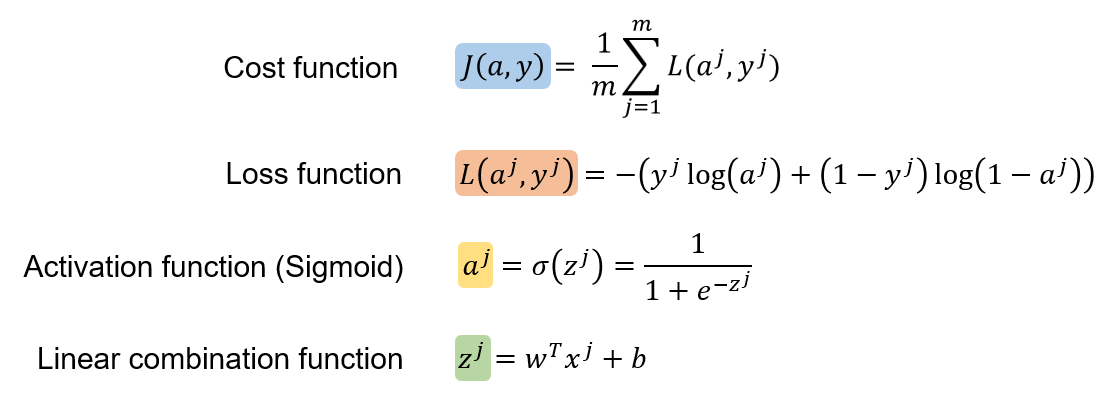

딥러닝 기초를 공부하다 보면 cost function과 loss function이 나오는데 정말 간단하게 설명하자면 loss function은 위에서 말했던 실제 값과 예상 값의 차이를 얘기하고, cost function은 모든 input 데이터의 loss function의 값의 평균을 얘기한다.

결국, 더 예측을 잘하는 딥러닝 모델을 만들기 위해서는 cost function의 값을 최대한 작게 만드는게 목표다.

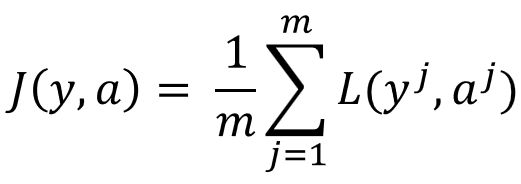

Cost function의 식은 이렇게 생겼다:

이제 문제는 어떻게 cost function의 값을 최대한 작게 만드는가이다!

딥러닝 모델의 파라미터 w와 b

Cost function의 식을 보면 w와 b가 없다. 하지만 위의 식을 구성하는 애들의 식을 보면 w와 b를 찾을 수 있다.

이렇게 식을 펼쳐 놓으면 우리가 수정할 수 있는 파라미터 w와 b가 cost function에 영향을 주는 값들인걸 알 수 있다. 즉, 딥러닝 모델을 최적화 시킬 때 우리의 목적은 w와 b 값들을 바꿔가면서 w와 b가 어떤 값일 때 모델이 예측을 더 잘하나(= cost function의 값이 가장 작은가)를 살펴보는 것이다!

이것이 역전파의 가장 기본적인 원리이다. 이제 역전파를 어떻게 실행하는지를 알아보자!

역전파 계산 논리

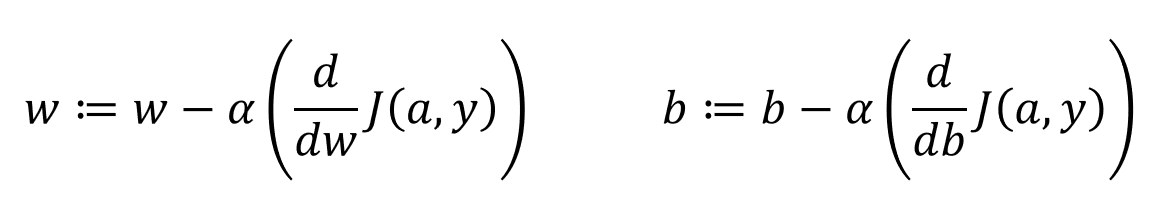

역전파를 계산할 때 이런 식을 많이 보게 된다:

그렇다. 미분이라는 것이다. 사실 미분은 쉽게 말해서 어떤 선의 기울기를 얘기한다. 즉, x가 바뀔 때 y는 얼마나 바뀌는가. 위의 식들을 해석하자면 w라는 값이 바뀔 때 J(a,y)의 값은 얼마나 바뀌는가, 그리고 b라는 값이 바뀔 때 J(a,y)의 값은 얼마나 바뀌는가를 보는 것이다. 여기서 J(a,y)는 위에서 설명했듯이 cost function이고, 우리의 목적인 w와 b 값들을 수정할 때 cost function이 얼마나 바뀌는지를 볼 수 있다.

이제 cost function이 줄어들게 만드는 w와 b의 값들을 구하면 된다!

경사 하강법(Gradient descent)

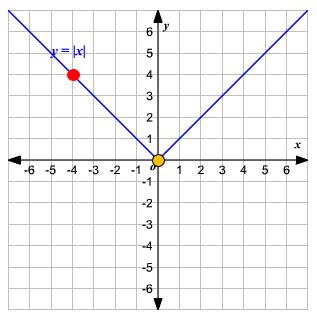

Cost function이 줄어들게 만들려면 경사 하강법(gradient descent)을 이용해야 한다. 경사 하강법을 아주 간단하게 설명하기 위해 절대값을 구하는 식을 예로 들어보자.

왼쪽편의 선의 기울기는 -1, 오른쪽편의 선의 기울기는 1이다. 왜냐면 왼쪽 선은 x가 -1씩 줄어들수록 y가 1씩 증가하고 (1 / -1 = -1), 오른쪽 선은 1씩 증가할수록 y가 1씩 증가(1 / 1 = 1)하기 때문이다.

만약 선 상에서 아무데나 점을 찍는다고 해보자.

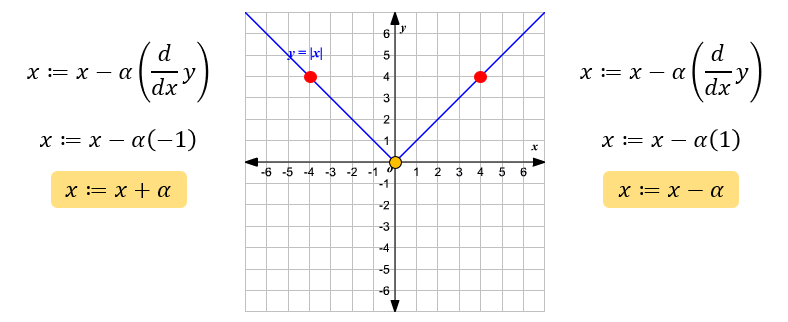

기울기가 1인 선 상에 점이 찍혔다. 이 점을 y가 가장 작은 위치인 노란 점이 있는 곳으로 이동하고 싶다면 어떻게 해야할까? 기울기 1 만큼씩 내려가면 된다! 그렇다면 점이 왼쪽 선에 찍혔다면?

노란 점에 도달하려면 기울기 -1 만큼씩 따라 내려가면 된다.

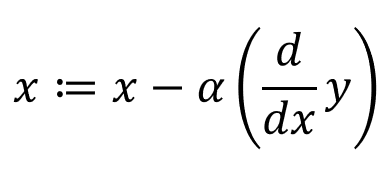

이 원리를 이용해 이런 식을 세울 수 있다:

":=" 이라는 기호는 x 값을 계속해서 업데이트 시켜준다는 뜻이다. 그리고 α는 learning rate라는 값인데 얼마나 빠르게 하강할지 조절해주는 값이다. 이 식을 이용한다면 위에서 본 경우를 아래와 같이 나눌 수 있다.

즉, 왼쪽에 점이 있을 땐 x에 α를 더해줌으로써 점을 오른쪽으로 이동해 y를 최소값으로 유도하고, 오른쪽에 점이 있을 땐 x에 α를 빼줌으로써 점을 왼쪽으로 이동해 y를 최소값으로 유도하게 된다. 이것이 경사 하강법의 기본적인 원리이다!

이제 이와 같은 논리를 cost function에 적용하면 된다. 대신 이번엔 w와 b라는 값을 위의 x처럼 업데이트 해줄 것이고, y 대신 J(a,y)라는 cost function을 사용하면 된다.

이것이 딥러닝 모델을 최적화 시킬 때 사용하는 계산법이다!

dw와 db 계산법

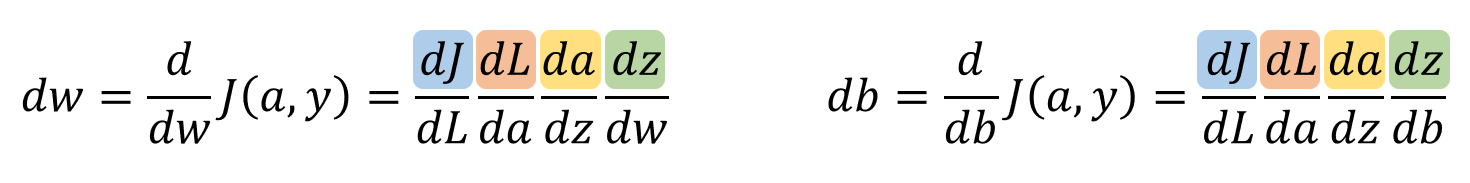

이제 w와 b를 계속 업데이트 시키면서 J(a,y)의 값을 줄이는 방법은 알게 되었다. 그런데 위에 보았던 dw와 db는 어떻게 계산하지? 여기서 좀 복잡해 보이는 미분 식들이 쏟아져 나온다.

사실 위에 설명한 것까지만 이해했다면 이 부분은 몰라도 괜찮다. 하지만 굳이 설명하자면 dw와 db 같은 복잡한 미분을 계산하기 위해선 chain rule이란걸 쓰게 된다. 말 그대로 쇠사슬 (chain) 고리에 고리를 연결하듯이 미분을 줄줄이 연결하면 된다.

J, L, a, z... 어디서 많이 보지 않았는가? 그렇다. 젤 처음에 설명했던 애들이다!

위의 식들을 모두 미분해서 해당 chain rule 식에 넣어 계산하면 끝이다. 어떻게 미분하는지가 궁금하다면 여기를 참고하면 아주 자세하게 잘 설명해준다.

아래는 미분된 식들이다.

이렇게 cost function부터 미분을 통해 거꾸로 거슬러 올라가 처음 계산식에 넣었던 w와 b를 수정하기 때문에 "역"전파라고 불린다. w와 b로 cost function을 계산하는 "순"전파(forward propagation)의 반대가 되는 것이다!

역전파 이해 완료~!

참고

Andrew Ng의 딥러닝 강의 - https://www.coursera.org/learn/neural-networks-deep-learning/lecture/6dDj7/backpropagation-intuition-optional

https://towardsdatascience.com/backpropagation-in-simple-terms-8df312471d32

https://medium.com/@pdquant/all-the-backpropagation-derivatives-d5275f727f60

'🤖 Deep Learning > 딥러닝 이론' 카테고리의 다른 글

| Scikit-Learn vs. TensorFlow (0) | 2023.06.01 |

|---|---|

| 딥러닝 표준 기호 (0) | 2023.05.11 |

댓글